Nos últimos anos, modelos de inteligência artificial (IA) abertos emergiram como uma alternativa poderosa aos modelos proprietários. Existem diferentes níveis de abertura na IA – alguns modelos compartilham apenas arquitetura e código, outros disponibilizam datasets, e os mais abertos incluem também os pesos treinados do modelo – por isso é importante esclarecer que “modelos abertos” (open models) nem sempre significa “pesos abertos” (open-weight).

Esses diferentes graus de abertura permitem que pesquisadores, pessoas desenvolvedoras e organizações usem, estudem, modifiquem e distribuam os sistemas com maior liberdade do que os modelos proprietários. Diferentemente dos modelos fechados (cujos componentes principais permanecem privativos de uma empresa), os modelos abertos promovem colaboração e transparência, democratizando o acesso às tecnologias de IA.

Neste artigo, exploramos a evolução desses modelos abertos, os avanços técnicos recentes, vantagens e desvantagens e as iniciativas de governança para uso responsável.

Evolução dos modelos abertos

A ideia de software aberto remonta aos anos 1980 com o movimento do software livre, e influenciou também a pesquisa em IA. Já nos anos 2000, começaram a surgir bibliotecas open source fundamentais de machine learning – como Scikit-learn (2007), OpenCV (2000) e Torch (2002) – que facilitaram a colaboração e a disseminação de algoritmos de IA.

Na década de 2010, o advento do deep learning impulsionou frameworks abertos como o TensorFlow (Google) e o PyTorch (Facebook), que tornaram redes neurais complexas acessíveis a desenvolvedores no mundo todo. Nesse período, vimos também os primeiros modelos pré-treinados de IA serem disponibilizados publicamente, como o BERT da Google (2018) e os primeiros modelos GPT da OpenAI, demonstrando o potencial dessas arquiteturas e estimulando interesse em IA open source.

Entretanto, nem todos os avanços seguiram abertos. Em 2019, a OpenAI causou debate ao decidir não liberar integralmente o GPT-2, citando riscos de uso malicioso. Após críticas da comunidade, o código do GPT-2 acabou sendo publicado alguns meses depois. Já os modelos GPT-3 (2020) e GPT-4 (2023) permaneceram fechados – disponíveis apenas via API, sem acesso aos pesos ou código. Essa postura catalisou esforços de pesquisa independente para criar alternativas abertas. Organizações e comunidades acadêmicas desenvolveram modelos livres inspirados nos GPTs (por exemplo GPT-J, GPT-Neo), e um consórcio internacional lançou o modelo BLOOM (176B) em 2022 sob licença aberta, provando que a colaboração global pode treinar modelos de escala semelhante aos proprietários.

Um marco importante foi a iniciativa da Meta em abrir seus large language models. Em 2022, a Meta liberou para pesquisadores o modelo OPT (175 bilhões de parâmetros) e, no início de 2023, anunciou o LLaMA – uma família de modelos de 7B a 65B de parâmetros – cujo peso completo foi compartilhado com a comunidade acadêmica. Embora o LLaMA 1 original tivesse uma licença restritiva (uso apenas para pesquisa), seus pesos vazaram online, levando a uma proliferação de versões afinadas pela comunidade (como Alpaca, Vicuna etc.). Reconhecendo o impacto, em julho de 2023 a Meta lançou oficialmente o LLaMA 2 sob licença aberta com permissão para uso comercial, o que o tornou o modelo de IA aberto mais avançado disponível até então. Essa decisão foi celebrada por permitir que empresas e pessoas desenvolvedoras construíssem aplicações em cima de um modelo de última geração sem pagar royalties. Em apenas alguns anos, passamos de um cenário dominado por modelos fechados para um ecossistema onde 65,7% dos novos modelos lançados em 2023 foram open-source, comparado a 44,4% em 2022. Em 2024, esse movimento continuou com lançamentos como o LLaMA 3.1 (405B parâmetros) pela Meta, reivindicado como comparável aos modelos fechados mais avançados, ainda que não sem controvérsia sobre o quão “aberta” essa disponibilização realmente foi.

Sobre os avanços recentes

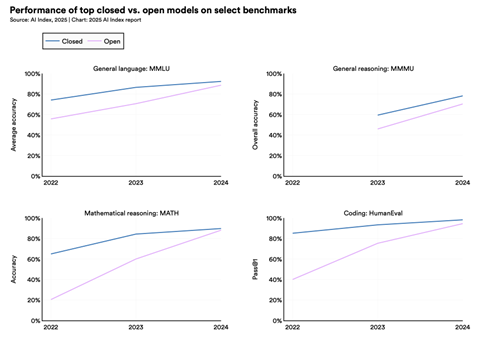

Os anos de 2023 a 2025 testemunharam um salto na qualidade e variedade dos modelos de IA abertos. Diversos laboratórios e startups introduziram modelos abertos que rivalizam em desempenho com as melhores IAs proprietárias. Um exemplo notável é o Falcon 40B, lançado em 2023 pelo Instituto de Inovação Tecnológica (TII) nos Emirados Árabes. Com 40 bilhões de parâmetros e licença Apache 2.0, o Falcon-40B alcançou o topo dos rankings de open LLMs ao superar modelos abertos concorrentes de maior porte (inclusive o LLaMA-65B da Meta) em benchmarks como MMLU e outros testes padronizados. Foi um dos primeiros modelos totalmente open source de grande porte a competir em igualdade com modelos fechados da geração anterior, demonstrando que conjuntos de dados refinados e arquitetura otimizada podem importar tanto quanto o tamanho bruto do modelo.

Nestor Maslej, Loredana Fattorini, Raymond Perrault, Yolanda Gil, Vanessa Parli, Njenga Kariuki, Emily Capstick, Anka Reuel, Erik Brynjolfsson, John Etchemendy, Katrina Ligett, Terah Lyons, James Manyika, Juan Carlos Niebles, Yoav Shoham, Russell Wald, Tobi Walsh, Armin Hamrah, Lapo Santarlasci, Julia Betts Lotufo, Alexandra Rome, Andrew Shi, Sukrut Oak. “The AI Index 2025 Annual Report,” AI Index Steering Committee, Institute for Human-Centered AI, Stanford University, Stanford, CA, April 2025.

Outro avanço veio da startup francesa Mistral AI, que em setembro de 2023 liberou o Mistral 7B sob licença Apache 2.0. Apesar de seu tamanho relativamente pequeno (7 bilhões de parâmetros), o Mistral 7B mostrou-se excepcional: ele ultrapassou o desempenho do LLaMA 2 de 13B em todos os benchmarks avaliados, e até superou o antigo LLaMA 34B em diversas tarefas. Em benchmarks de raciocínio e código, o Mistral 7B foi comparável a modelos três vezes maiores, indicando uma eficiência bastante notável. Essa otimização deve-se a inovações na arquitetura (por exemplo, Grouped-Query Attention para acelerar inferência e mecanismos eficientes de atenção deslizante) e a um treinamento cuidadoso com dados de alta qualidade. Em suma, o Mistral 7B provou que modelos abertos menores podem atingir performance de modelos bem maiores, tornando soluções de IA mais acessíveis em termos de custo e infraestrutura.

Paralelamente, a Meta continuou investindo em abertura responsável. O LLaMA 2, além de aberto comercialmente, passou a servir de base para inúmeros modelos especializados (como o Code Llama para programação e várias versões tunadas com feedback humano). A comunidade rapidamente adotou o LLaMA 2 como baseline para aplicações, dado que ele oferecia desempenho próximo ao GPT-3.5 da OpenAI em várias tarefas, mas podia ser executado localmente e de forma personalizada. Esse movimento sinaliza que empresas líderes veem valor estratégico em modelos “abertos” (mesmo que sujeitos a certas licenças). O treinamento de um dos modelos mais recentes, o LLaMA 3.1, envolveu enorme poder computacional – emitindo ~8.930 toneladas de CO₂, mais que as 5.184 toneladas estimadas para treinar o GPT-4 – mostrando que a fronteira dos modelos abertos já atinge escalas de última geração.

Tecnicamente, benchmarks recentes evidenciam o progresso rápido dos modelos abertos. Em 2022, o menor modelo capaz de superar 60% de acurácia no difícil teste MMLU tinha 540 bilhões de parâmetros (o PaLM do Google); já em 2024, um modelo de apenas 3,8B (Microsoft Phi-3-mini) alcançou o mesmo patamar – uma redução de 142x no tamanho em dois anos. Esse salto reflete melhores algoritmos de treinamento, arquiteturas otimizadas e uso de instrução/fine tuning que extrai mais capacidade de cada parâmetro.

Além disso, vimos expansões para outras modalidades: modelos focados em imagem como o Stable Diffusion (2022) revolucionaram a geração visual aberta, e em 2024 já surgem geradores de vídeo open-source de alta qualidade, ressaltando a rapidez e a especialização constantes.

Vantagens e desvantagens

Como qualquer tecnologia, os modelos de IA abertos trazem benefícios significativos, mas também desafios e riscos em comparação aos sistemas proprietários. Abaixo, resumimos os principais pontos:

| Vantagens | Desvantagens |

|---|---|

| Custo/escalabilidade

Modelos abertos eliminam custos de licença ou uso de API – uma vez treinados ou baixados, podem ser executados localmente quantas vezes forem necessárias. Isso pode reduzir drasticamente o custo por transação de IA, especialmente quando há alto volume de requisições. Entre 2022 e 2024, o custo de inferência de LLMs caiu mais de 200x, muito em função de modelos abertos, menores e mais eficientes. Além disso, não há dependência de fornecedor: organizações podem escalar o uso conforme sua infraestrutura, sem limites impostos por contratos de serviço. |

Recursos

Apesar do rápido progresso, em geral os modelos abertos ainda atingem performance ligeiramente inferior aos fechados de última geração nas tarefas mais complexas. Modelos proprietários como GPT-4 dispõem de ordens de magnitude bem maiores de parâmetros (treinados com custo de dezenas de milhões de dólares), enquanto a comunidade open nem sempre possui tais recursos. Assim, para quem precisa do estado-da-arte máximo em determinadas métricas (por exemplo, obter >85% no MMLU ou resolver perfeitamente questões matemáticas difíceis), os modelos fechados ainda entregam resultado superior. Além disso, manter e treinar modelos abertos grandes é custoso – poucas organizações têm infraestrutura para treinar um modelo de 100B+ de parâmetros do zero. Ou seja, há um desafio de recursos computacionais: muitas vezes dependemos que grandes empresas (Meta etc.) decidam abrir seus modelos já treinados; caso contrário, a comunidade sozinha pode demorar mais para alcançar certos patamares. |

| Transparência

Uma vantagem central da IA aberta é a transparência. Com acesso ao código-fonte e, em alguns casos, aos pesos do modelo, pessoas desenvolvedoras podem inspecionar como a IA toma decisões, aumentando a prestação de contas (accountability) e permitindo compreender e explicar o comportamento do modelo. Por exemplo, em aplicações críticas (saúde, finanças, justiça), é valioso poder auditar internamente o sistema para verificar vieses ou erros de lógica. Além disso, a possibilidade de “abrir a caixa-preta” facilita pesquisas para reduzir vieses e melhorar a equidade do modelo, já que é possível analisar diretamente os parâmetros em busca de preconceitos aprendidos. Essa transparência contrasta com modelos fechados, onde muitas vezes só se conhece as entradas e saídas, dificultando a detecção de problemas. |

Segurança

Um ponto de preocupação é que, uma vez que um modelo é aberto, não há como “despublicá-lo” se surgir um problema grave. Se vulnerabilidades ou possibilidades de abuso forem descobertas, o modelo já estará em domínio público. Por exemplo, modelos de código aberto podem ser afinados por terceiros para gerar conteúdo malicioso removendo restrições de segurança que existiam em versões originais. Há casos em que modelos abertos foram deliberadamente ajustados para produzir discursos de ódio ou orientar atividades ilegais – como o polêmico GPT-4Chan, um modelo aberto derivado que replicava linguagem tóxica de fóruns. Modelos fechados, ao contrário, são controlados centralmente (pelo provedor) que pode impor atualizações de segurança ou limitar certas saídas. Com open source, qualquer um pode pegar os pesos e usá-los para qualquer fim, o que inclui atores mal-intencionados. Assim, o potencial de uso indevido é maior, pois não há uma entidade única moderando a utilização. |

| Customização/flexibilidade

Com modelos abertos, empresas e comunidade podem ajustar e aprimorar o sistema livremente. É possível realizar fine-tuning do modelo nos dados específicos de um domínio (jurídico, biomédico etc.) para aumentar a acurácia em casos de uso particulares – algo que modelos proprietários raramente permitem (ou cobram caro por isso). Também é viável integrá-los a sistemas locais sem conexão à internet, adaptá-los a hardware customizado, ou até modificar a arquitetura da rede neural para experimentar novos recursos. Essa liberdade de adaptação impulsiona a inovação: pessoas desenvolvedoras independentes ao redor do mundo contribuem com melhorias e correções, levando a avanços mais rápidos do que o ciclo típico de produto fechado. Isso permite que startups ou mesmo pesquisadores individuais construam em cima do estado-da-arte, sem barreiras financeiras ou jurídicas. |

Vieses e riscos éticos

Todo modelo de IA reflete os dados nos quais foi treinado – incluindo vieses e conteúdo problemático. No caso dos modelos abertos, embora a transparência permita auditoria, na prática muitos modelos são lançados sem passar por um processo rigoroso de avaliação ética e mitigação de vieses (bias, em inglês). Um estudo que analisou mais de 100 mil modelos de IA abertos em repositórios encontrou que 30% deles continham vulnerabilidades de alta severidade no código ou comportamento. Além disso, desenvolvedores independentes às vezes focam tanto em desempenho que negligenciam documentar limitações ou riscos de seus modelos. Menos de 28% dos projetos abertos analisados incluíam preocupações com qualidade de dados em sua documentação, por exemplo. Em comparação, empresas tendem, ao menos por questões de reputação, a avaliar vieses e a segurança de seus modelos antes do lançamento, e frequentemente aplicam filtros de moderação nas APIs. Com modelos abertos, essa responsabilidade recai individualmente sobre quem implementa o modelo, que pode ou não ter expertise para tal. Sem governança central, há o risco de modelos abertos perpetuarem ou até exacerbarem vieses se utilizados ingenuamente, além de bugs de segurança permanecerem sem correção. |

| Autonomia

Ao optar por um modelo aberto, organizações mantêm os dados sob seu controle, processando localmente informações sensíveis em vez de enviá-las a uma API de terceiros. Isso pode aumentar a segurança e privacidade, pois reduz a exposição de propriedade intelectual ou dados de clientes. No setor público e na saúde, a independência de um modelo aberto é vista como forma de evitar ficar refém de um provedor que pode mudar termos ou até desativar o serviço. Caso um provedor feche as portas ou decida remover acesso a certo modelo, uma instituição ficaria desamparada – algo que não ocorre quando ela própria detém o modelo. Assim, modelos abertos oferecem uma garantia de continuidade: o código e pesos podem viver indefinidamente em repositórios públicos, disponíveis para uso mesmo se o autor original interromper suporte. |

Suporte e manutenção

A falta de suporte formal é outro ponto desfavorável dos modelos abertos. Enquanto modelos fechados vêm geralmente com contrato de suporte (SLA) e equipes dedicadas para correção de problemas, um modelo aberto não oferece garantias. Se um bug crítico é encontrado, depende da comunidade (ou do mantenedor voluntário) corrigi-lo – o que pode levar tempo ou nunca ocorrer, se o projeto perder atenção. Empresas adotando modelo aberto internamente precisam ter ou contratar equipes técnicas para ajustar o modelo, fazer deploy, monitorar desempenho e segurança ao longo do tempo. Esse custo de manutenção pode ser significativo e às vezes subestimado. Além disso, atualizações não são automáticas: se surge um modelo melhor, a migração fica por conta da empresa. Em contraste, usando um serviço fechado, a atualização para uma nova versão é muitas vezes transparente (o provedor cuida disso). Assim, organizações devem pesar se possuem maturidade técnica para colher os benefícios da IA aberta sem o apoio tradicional de um vendor. Para muitas, vale a pena pelo controle que ganham; para outras, essa responsabilidade extra pode ser uma desvantagem dependendo do caso de uso. |

| Colaboração

Modelos abertos se beneficiam do ecossistema colaborativo. Milhares de pessoas testando e aprimorando o modelo tendem a encontrar bugs e propor otimizações rapidamente. Essa inteligência coletiva levou, por exemplo, a projetos de crowdsourcing de alinhamento e segurança (como o OpenAI Eval e Hugging Face Hub) em que voluntários ajudam a tornar os modelos mais seguros e úteis para todos. A cultura open-source historicamente acelera o ritmo de inovação, e na IA não é diferente: iniciativas como a BigScience (que produziu o BLOOM) mostraram que unir pesquisadores globalmente em torno de um modelo aberto pode resultar em saltos de qualidade e em melhores práticas de desenvolvimento ético. |

Em síntese, os modelos abertos trazem vantagens claras em custo, transparência, flexibilidade e independência, mas cobram um preço em termos de maior responsabilidade da pessoa usuária na gestão de riscos e performance. Muitas dessas desvantagens estão sendo atenuadas conforme a comunidade desenvolve melhores práticas de lançamento e ferramentas de segurança open-source, porém empresas devem considerar esses trade-offs cuidadosamente ao avaliar a adoção de IA aberta.

Os governos também começam a agir. Em 2024, por exemplo, aumentou a cooperação internacional em governança de IA: organizações como OCDE, União Europeia, Nações Unidas e União Africana publicaram marcos com princípios para IA responsável, enfatizando transparência, explicabilidade e segurança. Embora focados em IA como um todo, muitos desses princípios apoiam a abertura (transparência de algoritmos) ao mesmo tempo que pedem mecanismos para mitigar riscos. Nos EUA, um relatório presidencial em julho de 2024 avaliou possíveis restrições à liberação de pesos de modelos, concluindo que não havia evidências suficientes para proibir a divulgação – sinalizando, por ora, uma abordagem permissiva e pró-open source por parte do governo americano. Já a União Europeia, via AI Act, discute exigir que modelos base (foundation models) com certas capacidades sigam requisitos de documentação e mitigação de vieses, o que afetaria também modelos de código aberto de alto desempenho. Ou seja, regulações futuras podem introduzir obrigações de transparência e controle mesmo para projetos open-source, buscando equilibrar inovação e proteção.

Os modelos de IA abertos já se firmaram como peça central no panorama da inteligência artificial moderna. Sua origem colaborativa e evolução rápida demonstram o poder da inovação distribuída – em poucos anos, projetos open-source alcançaram níveis técnicos antes restritos a corporações bilionárias. Ao mesmo tempo, a disseminação ampla dessas ferramentas traz responsabilidade: é preciso continuar desenvolvendo padrões de governança, documentando e monitorando o impacto dos modelos e garantindo que os benefícios sejam colhidos sem ignorar os riscos. Para empresas e pessoas desenvolvedoras, os modelos abertos oferecem um caminho empolgante de autonomia e economia, desde que cientes das obrigações de gerir a tecnologia de forma diligente. Olhando à frente, iniciativas de IA aberta e responsável – unindo transparência técnica com conscientização ética – serão cruciais para que a democratização da IA se traduza em ganhos para toda a sociedade. Constrói-se gradualmente um ecossistema onde abrir um modelo não significa “largá-lo no mundo e lavar as mãos”, mas sim disponibilizá-lo com contexto, advertências e até ferramentas auxiliares para seu uso seguro. Afinal, uma comunidade bem informada e engajada pode tornar os modelos abertos não apenas mais acessíveis, mas também mais seguros, justos e alinhados com nossos valores coletivos.

Este conteúdo faz parte da ProgaMaria Sprint Primeiros Passos em Tecnologia

Autora

Mikaeri Ohana é Gerente de Dados e IA, mestranda em Inteligência Artificial pela Unicamp e fundadora da Escola Tesseract. Atua em carreira tech desde 2015, focada em Data Science desde 2018. Foi premiada pelo Microsoft MVP em IA, Google Dev Expert em Machine Learning e LinkedIn Top Voice. Lidera iniciativas de dados na CI&T, é mentora de startups e, através do @explicami, democratiza o ensino de Dados e IA para profissionais no Brasil e mundo. https://www.linkedin.com/in/mikaeriohana

Revisora

Luciana Fleury, jornalista https://www.linkedin.com/in/luciana-fleury-1b024083/