Introdução

Imagine um especialista em culinária que sabe tudo sobre comida — receitas, ingredientes, técnicas —, mas que não sabe cozinhar. Essa é a limitação dos Large Language Models (LLMs): modelos superinteligentes, mas que, sozinhos, apenas geram texto.

Isso está mudando com o uso de Tools, ferramentas que permitem aos LLMs agir no mundo real. Neste artigo, vamos descomplicar esse tema, mostrar como essas ferramentas funcionam e explorar casos de uso que revelam seu verdadeiro potencial.

O que são Large Language Models?

Antes de falarmos sobre as Tools, é importante relembrar o que são os LLMs —Large Language Models ou modelos de linguagem de grande porte: são modelos de inteligência artificial desenvolvidos e treinados com uma quantidade extremamente grande de dados para gerar novos conteúdos, como textos, imagens, vídeos, entre outros.

Os LLMs representam uma verdadeira revolução no campo da inteligência artificial. Eles são capazes de compreender e gerar linguagem natural com fluência, contexto e adaptabilidade nunca vistos antes. Podem escrever textos, responder perguntas, traduzir idiomas, gerar código, resumir documentos, explicar conceitos complexos e até conversar de forma bastante natural.

Esses modelos são treinados com bilhões (ou até trilhões) de dados de diversos formatos, extraídos de diversas fontes. Isso os torna versáteis o suficiente para atuar em áreas como educação, atendimento ao cliente, marketing, engenharia de software e muitas outras.

Como Criar uma Tool para Modelos de Linguagem (LLMs)

Você já interagiu com um chatbot como o ChatGPT e se perguntou como ele poderia fazer algo prático — como buscar a previsão do tempo, acessar um sistema ou até executar um código? Para que isso aconteça, os modelos de linguagem precisam de algo a mais do que apenas “escrever bem”. Eles precisam de Tools.

O que são Tools?

Tools (ou ferramentas) são serviços ou funções externas que um modelo de linguagem pode usar automaticamente, sempre que precisa realizar algo que vai além da simples geração de texto. Exemplos: buscar a previsão do tempo, consultar um banco de dados, enviar um e-mail ou realizar um cálculo. Em outras palavras, uma Tool é como um superpoder extra que damos ao modelo, para que ele possa agir, e não apenas responder com palavras.

Quais serviços ajudam a criar Tools?

Para que um modelo de linguagem saiba quando e como usar uma ferramenta, precisamos integrá-la por meio de alguma plataforma. Duas das mais populares atualmente são:

- OpenAI Function Calling: esse recurso da OpenAI permite ao modelo reconhecer, por meio de linguagem natural, que precisa chamar uma função externa. Ideal para conectar o modelo com APIs e sistemas reais.

Documentação oficial - LangChain Tools: esse framework open source (framework de código aberto) permite a criação de aplicações mais avançadas com LLMs, como agentes que tomam decisões, respondem perguntas e automatizam fluxos de trabalho. Com ele, é possível registrar funções Python como “tools” e permitir que o modelo as utilize de forma dinâmica.

Documentação oficial

Criando uma Tool (Exemplo com OpenAI)

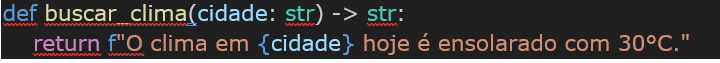

Vamos imaginar que você quer que o modelo informe o clima de uma cidade. Para isso, criaremos uma função chamada buscar_clima.

1, Criar a função Python

Essa função simula uma resposta sobre o clima. Veja como ela é simples:

Em uma aplicação real, essa função acessariareceb uma API como OpenWeather ou Climatempo.

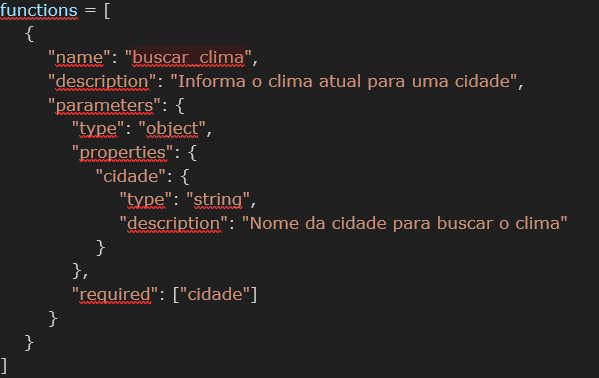

2. Informar ao modelo como essa função funciona

Precisamos explicar ao modelo como usar a função. Isso é feito por meio de um schema, que descreve o nome da função, o que ela faz e quais informações ela precisa:

O que cada campo significa:

| Campo | O que faz |

|---|---|

| name | Nome da função que será chamada pelo modelo |

| description | Explica o que a função faz |

| parameters | Indica quais dados são necessários |

| type | Diz que os parâmetros virão como um “objeto” (estilo dicionário) |

| properties | Lista e detalha os campos específicos que precisamos receber no momento que a Tool é acionada. |

| required | Indica que “cidade” é obrigatório para o funcionamento da função |

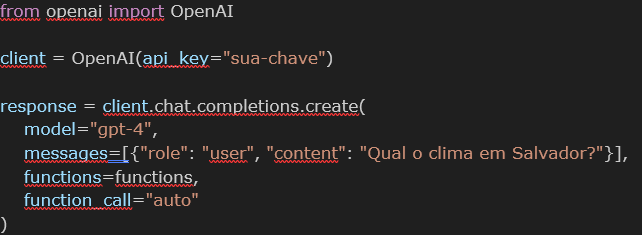

3. Fazer o modelo usar a função

Com tudo configurado, agora o modelo já pode usar a função:

Veja que neste comando “functions=functions” estamos informando para o modelo quais são as funções disponíveis que ele pode utilizar.

O que acontece nesse processo:

a. O usuário faz uma pergunta.

b. O modelo percebe que precisa buscar uma informação.

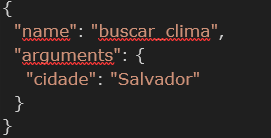

c. Ele chama a função buscar_clima, passando “Salvador” como argumento.

d. Recebe o retorno da função e entrega a resposta final ao usuário.

4. Exemplo de fluxo completo

Requisição gerada pelo modelo:

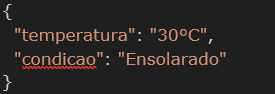

Resposta da função:

Resposta final para o usuário:

” O clima em Salvador hoje é ensolarado, com 30°C “

Casos de Uso

Agora que já entendemos o que são as Tools e como funcionam, vamos explorar onde elas podem ser aplicadas. Os casos de uso estão crescendo rapidamente, à medida que essas ferramentas se integram a soluções do dia a dia. Neste artigo quero compartilhar com você um caso de uso que tenho muito orgulho de ter participado.

Caso de Uso: Automatizando a Revisão de Código com IA

No desenvolvimento de software, um passo essencial é a revisão de código (code review). Nela, alguém do time analisa o que foi alterado antes de aprovar e integrar ao sistema. Esse processo garante que o código esteja claro, seguro e dentro dos padrões da equipe. Mas essa etapa pode ser lenta e cansativa, principalmente quando há muitas alterações ou faltam pessoas disponíveis para revisar.

O que desenvolvemos?

Criamos uma ferramenta que funciona junto ao GitHub. Toda vez que uma pessoa desenvolvedora abre um pull request, o sistema envia automaticamente as alterações para um modelo de IA (GPT-4), que analisa o código e retorna com comentários, como se fosse um colega da equipe.

A IA pode:

- Ler as mudanças no código

- Apontar possíveis problemas

- Sugerir melhorias

- Comentar diretamente no GitHub

Benefícios dessa automação

- Acelera o processo de revisão

- Libera o time para tarefas mais estratégicas

- Reduz erros e melhora a qualidade desde o início

A IA atua como um copiloto técnico, oferecendo uma primeira camada de análise, sem substituir o olhar humano.

Como funciona por dentro?

- Uma pessoa desenvolvedora abre um pull request.

- O sistema envia o código para a IA.

- Um prompt orienta a análise do modelo.

- A IA gera comentários e sugestões com base no conteúdo recebido.

Um ponto de atenção: Mesmo sendo avançada, a IA trabalha com probabilidades. Isso significa que ela pode errar ou interpretar algo de forma equivocada. Por isso, é fundamental que o prompt (instrução) esteja claro e que o time revise os resultados. Essa solução mostra como a IA pode agilizar processos, apoiar decisões técnicas e trazer valor real ao trabalho em equipe.

Estratégia de desenvolvimento, desafios e aprendizado

Um dos maiores desafios do projeto foi refinar o prompt — ou seja, a forma como instruímos o modelo para fazer o que queremos. No começo, tínhamos apenas uma ideia geral de como a solução deveria funcionar, mas ainda não uma estratégia de desenvolvimento bem definida. Isso tornava o processo ainda mais difícil.

Além disso, precisávamos que o modelo analisasse tanto códigos de front end quanto de back end, o que exigia um equilíbrio delicado: o prompt precisava ser amplo o suficiente para cobrir os diferentes contextos, mas claro o bastante para evitar respostas vagas ou erradas.

Para ilustrar: era como tentar ensinar alguém a cozinhar dando instruções pela porta, sem ver o que ela estava fazendo. Em certo momento, o modelo começou a “alucinar” — ou seja, gerar respostas absurdas ou desconectadas — a ponto de eu me sentir completamente perdida.

Foi com apoio do time e feedback constante dos principais stakeholders que conseguimos ajustar a rota. A cada nova tentativa, refinamos o prompt, testamos diferentes cenários, analisamos as respostas e aprendemos com os erros. O processo foi como afinar um instrumento musical: cada pequeno ajuste fez uma diferença significativa no resultado.

No fim, conseguimos construir um serviço robusto e eficiente. E aprendemos, na prática, que conversar com um modelo de linguagem é como dar instruções a um assistente muito talentoso, mas que precisa de orientações claras e bem pensadas para entregar seu melhor.

Ao desenvolver essa solução, uma das decisões mais importantes foi definir a estratégia de revisão de código. Afinal, automatizar o processo não significava simplesmente jogar tudo para o modelo analisar. Pelo contrário — sem critério, a automação poderia acabar mais atrapalhando do que ajudando.

Pensamos em algumas abordagens iniciais:

- Revisar todo o repositório a cada nova pull request? Totalmente inviável. O volume de arquivos seria enorme, gerando análises lentas, caras e, muitas vezes, desnecessárias.

- Revisar todos os arquivos alterados? Também não fazia sentido. Pequenas mudanças em um arquivo podem impactar vários outros, mas nem todos exigem atenção.

Foi aí que optamos por uma abordagem mais focada e inteligente: a IA analisaria somente as alterações feitas na pull request. Com isso, o modelo se concentra no que realmente mudou — evitando excesso de informação, mantendo o contexto, e oferecendo sugestões mais úteis e direcionadas.

Podemos pensar assim: se o repositório fosse um livro, revisar tudo seria reler o livro inteiro sempre que mudássemos uma vírgula. Em vez disso, passamos a revisar só o parágrafo alterado, o que torna o processo mais ágil, econômico e relevante.

Nesse caso, menos foi mais. Reduzimos o escopo da revisão, mas aumentamos o valor do feedback gerado. Automatizar, nesse contexto, foi saber priorizar o que realmente importa — respeitando o fluxo de trabalho do time e tornando a IA uma parceira de verdade, e não mais um obstáculo no caminho.

Conclusão

Os LLMs já revolucionaram a geração de conteúdo, mas é com as tools que eles realmente se tornam úteis no mundo real. Com essas integrações, os modelos deixam de apenas responder e passam a executar ações, como consultar APIs, automatizar tarefas ou apoiar decisões.

Neste artigo, vimos como criar uma tool de forma simples, exploramos serviços como OpenAI Function Calling e LangChain, e aplicamos esse conhecimento em um caso real de automação de revisão de código. As ferramentas ampliam o impacto da IA generativa e abrem espaço para soluções mais inteligentes no dia a dia — seja em tecnologia, produto ou negócios.

Quer dar o próximo passo? Teste uma tool, conecte um modelo à sua rotina e veja como a IA pode ir além das palavras.

Recomendações

- Comprehensive Guide to Integrating Tools and APIs with Language Models – tutorial detalhado com exemplos de function calling e orquestração ai.

- How Do Professionals Use LLM Tools and Frameworks? (DataTalks.Club) – levantamento sobre uso de plataformas como OpenAI, LangChain e AWS club.

- LLM Integration – Key Tools and Techniques (Mirascope) – apresenta práticas recomendadas de integração e arquitetura com LLMs com.

- Building Agentic AI Systems – foca em arquitetura e implementação de agentes LLM que orquestram tools e aprendem com falhas com+1quiq.com+1.

Este conteúdo faz parte da ProgaMaria Sprint IA Generativa

Autora

Caroline Soares é Engenheira de Software. Graduada em Análise e Desenvolvimento de Sistemas e com MBA em Engenharia de Software. Possui experiência com Dados, IA Generativa, Python, AWS e arquitetura de microsserviços. Apaixonada por escrever documentação técnicas descomplicadas. Nas horas vagas, maratona doramas coreanos e chineses, faz crochê para relaxar e é mãe de dois doguinhos. https://www.linkedin.com/in/caroline-soares-0ba238107/

Revisora

Luciana Fleury, jornalista https://www.linkedin.com/in/luciana-fleury-1b024083/