Quais são os impactos da IA para a sociedade? É possível garantir sistemas que sejam éticos, justos e transparentes? Qual a relação entre Algoritmos de Inteligência Artificial e vieses?

Refletir sobre os impactos da Inteligência Artificial (IA) para a sociedade, além da questão da substituição dos trabalhos por processos automatizados, implica pensar vieses e processos éticos e justos.

Com o uso cada vez mais frequente dos sistemas de Inteligência Artificial hoje para a resolução de problemas e na tomada de decisões, a discussão sobre algoritmos que não repliquem processos discriminatórios e preconceituosos é cada vez mais importante.

Já existem tecnologias de IA avaliando pontuação de crédito para liberação de empréstimos, apoiando decisões judiciais relacionadas a fianças e condenações, rotulando e associando imagens, e acelerando processos seletivos.

Neste texto, vamos discutir a importância de se entender esse processo e caminhos possíveis para lidar com esse fenômeno.

O que você precisa saber sobre Algoritmos de IA e Vieses

O que é viés?

Na definição do dicionário Michaelis, viés é uma “tendência associada ou determinada por fatores externos”. O viés, então, pode ser entendido como uma associação gerada por nosso cérebro de forma quase automática:

Fonte: Machine Learning e o viés da vida real

Fonte: Machine Learning e o viés da vida real

São, portanto, mecanismos do cérebro para realizar rapidamente associações, com base nas experiências e cenários vivenciados pela pessoa e herança ancestral, que pode levar a tomada de decisões conhecidas e seguras. Ainda assim, os vieses não necessariamente funcionam da mesma forma. Para entender como funcionam os vieses a partir da neurociência e da psicologia, leia o material “Vieses inconscientes, equidade de gênero e o mundo corporativo”, da ONU Mulheres e Movimento Mulher 360.

Existem vários tipos de vieses. Alguns dos mais conhecidos são:

- Viés de afinidade: tendência a avaliar melhor o que é similar a coisas conhecidas para nós;

- Viés de percepção: quando as pessoas acreditam e reforçam estereótipos sem base concreta em fatos;

- Viés confirmatório: disposição para buscar informações que confirmem nossas hipóteses e ignorem as que contradigam;

- Efeito de auréola (efeito halo): propensão de ter mais disposição a avaliar positivamente o restante das informações a partir de uma única informação positiva ou agradável;

- Viés de grupo: seguir o padrão de um grupo, levando à concordância de uma mesma ideia.

Para ver mais tipos de vieses, recomendamos a leitura deste artigo, e da figura abaixo.

20 tipos de vieses cognitivos. Fonte: Foi rápido ou devagar?

20 tipos de vieses cognitivos. Fonte: Foi rápido ou devagar?

Mas vieses são sempre ruins? Não.

O problema dos vieses é o risco que estas associações ‘automáticas’ trazem para a perpetuação de processos discriminatórios que impactam nas desigualdades entre as pessoas.

A discussão sobre vieses existe em vários cenários, e está permeada por muitos debates sobre questões éticas e morais. Falar sobre vieses implica falar sobre desigualdade e discriminação por questões como gênero, raça, idade, orientação afetiva-sexual, linguagem, cultura, deficiência, condição econômica, entre outros fatores e suas interseccionalidades. E a gente sabe o quanto estes temas rendem debates!

Veja este vídeo sobre como se expressa o racismo institucional por meio destas ‘associações automáticas’.

Fonte: Racismo Institucional – Teste de Imagem – Campanha Governo do Paraná

Para saber mais:

O Projeto IMPLICIT (Implícito, na tradução), uma organização sem fins lucrativos fundada em 1998 por cientistas nos Estados Unidos, criou os Testes de Associação Implícita para mensurar o nível de viés inconsciente de uma pessoa em relação à raça, gênero, orientação sexual etc. O teste também está disponível em português.

E este debate vale para a tecnologia também.

A tecnologia não é imparcial: os algoritmos são processos matemáticos e são as pessoas quem os constroem. Não é raro vermos soluções que usam tecnologias de Inteligência Artificial apresentando vieses racistas, sexistas e classistas, como aplicativos que ao prometerem embelezar o rosto das pessoas, as embranquecem, diminuem seus narizes e aumentam seus olhos.

Algoritmos de Inteligência Artificial (IA) e Vieses

Apesar de ser usada para aumentar a eficácia de processos, e se dar de forma quase completamente automatizada em muitas aplicações, sendo conhecida por sua capacidade de “pensar sozinha”, não se pode esperar que a inteligência artificial seja “neutra, objetiva e infalível”.

A precisão da IA depende, em grande parte, da qualidade dos dados e dos parâmetros codificados nos algoritmos de treinamento. Deste modo, a IA reflete os padrões de pensamento de quem a criou. “Ignorar os processos produtivos e tecnológicos destes mecanismos pode levar a uma atribuição de objetividade e racionalidade a resultados que podem estar carregados de subjetividade e vieses discriminatórios”, escreve a professora Fernanda Carrera no artigo Racismo e Sexismo em bancos de imagens digitais, no livro Comunidades, Algoritmos e Ativismos Digitais: Olhares Afrodiaspóricos, com organização de Tarcízio Silva.

Se os vieses são resultado humano de interações e comportamentos sociais, como são introduzidos em inteligências artificiais?

Podem ser de várias maneiras, intencionalmente ou não. Algumas relacionadas aos dados utilizados como inputs (entradas) para os algoritmos, e algumas relacionados ao funcionamento interno e projeto do algoritmo. No artigo do Grupo de Comput{ação social} da USP, é possível explorar ainda mais o problema de Inteligências Artificias e Preconceitos Reais.

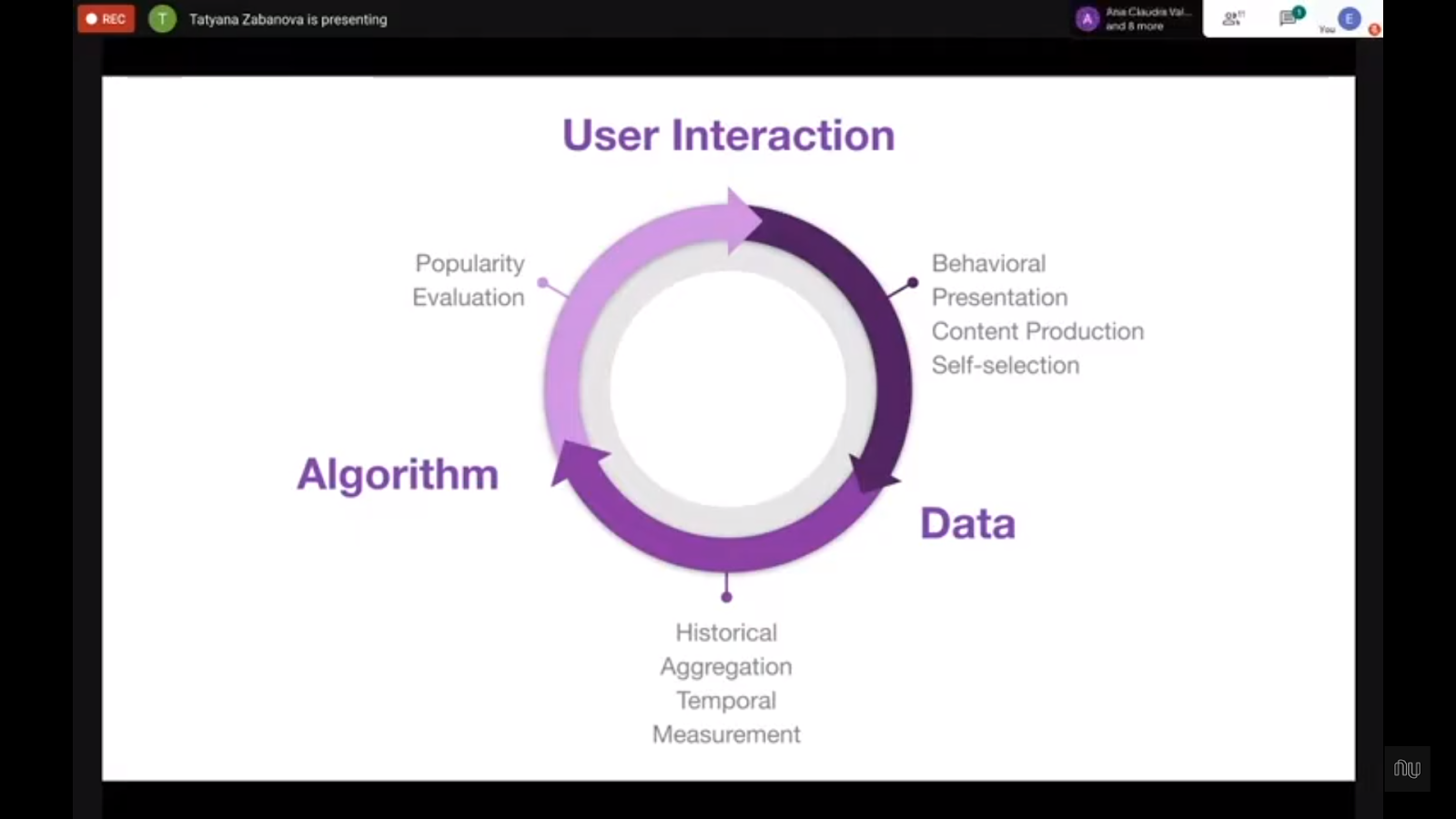

Créditos Tatyana Zabanova

Os vieses também “entram” por meio dos dados:

- A introdução de dados limitados ou mal selecionados, favorecendo alguns dados.

- Dados incompletos, desatualizados, ou incorretos, gerados pela coleta pouco rigorosa ou imprecisa.

- Dados que não representam a população ou grupo, obtidos pela aplicação do viés de seleção, podendo favorecer alguns grupos.

- Dados que refletem resultados passados, que podem ser discriminatórios e podem perpetuar vieses de forma não intencional.

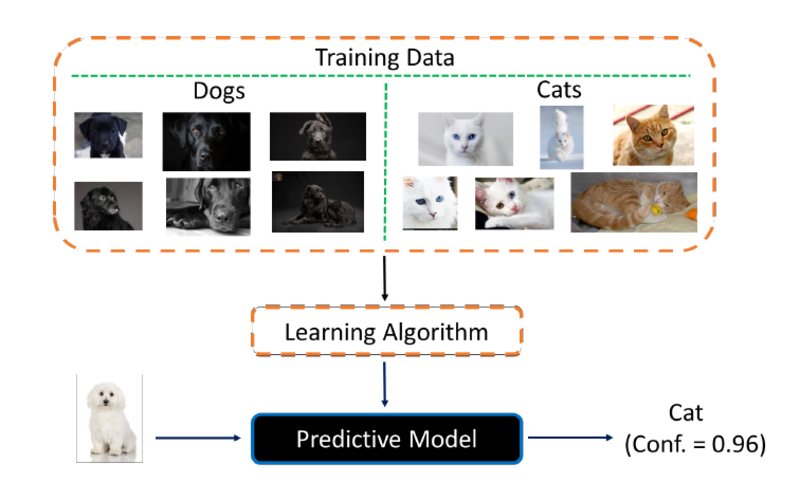

Neste exemplo simplificado, a escolha de dados de entrada incluem apenas imagens de cachorros pretos e de gatos claros, e o resultado é o reconhecimento de um cachorro branco como gato, com confiança de 96%. Fonte: Inteligências Artificiais, preconceitos reais

Alguns enviesamentos relacionados ao funcionamento interno e ao projeto do algoritmo:

- Sistemas de pareamento mal projetados: podem ser discriminatórios se não considerarem vieses históricos;

- Algoritmos de recomendação e personalização que diminuem o fluxo de informações, usados para inferir preferências e interesses, pode limitar o fluxo de informações, gerando um acesso desigual de oportunidades;

- Algoritmos enviesados por conta do conjunto de dados usados no treinamento, os quais eram previamente limitados ou incompletos. Isso realimenta padrões discriminatórios de algoritmos;

- Sistemas de tomada de decisão que assumem que correlação implica causação. A co-ocorrência frequente de dois fatores (como uma determinada etnia e determinada classe econômica) é usada como indicador de uma relação causal, levando a resultados discriminatórios.

Veja alguns casos de algoritmos de IA e vieses de gênero, raça etc. na tecnologia:

- Uso não reconhecido do pronome “hers” (dela, em inglês) em sistemas de IA. O pronome “hers” não era reconhecido pela maioria das tecnologias de Processamento de Linguagem Natural, incluindo Amazon Comprehend, Google Natural Language API, e Stanford Parser. Este vídeo mostra os exemplos de uso de “hers” em comparação com “his” em tecnologias de Machine Learning.

- Alexa não reconhece sotaques.

- Tribunais dos Estados Unidos vs população negra. Tribunais dos Estados Unidos estão usando programas de computador para prever quem será uma pessoa criminosa. Os programas influenciam todas as decisões judiciais, de fianças a condenações; e foram criados com o objetivo de tornar o sistema de justiça criminal mais justo, eliminando preconceitos humanos. A ProPublica testou um desses programas, o COMPAS, e descobriu que ele está frequentemente errado – além de ser tendencioso contra as pessoas negras. A comparação mostrou que o programa tende a apontar erroneamente réus negros como futuros criminosos, colocando-os na categoria de possíveis reincidentes quase duas vezes mais do que os réus brancos. Estes também foram classificados mais frequentemente como menos perigosos do que os réus negros.

- Pessoa na cozinha? Mulher! Um homem calvo, de uns 60 anos, mexe com suas espátulas de madeira alguns pedaços de carne dentro da frigideira. Usa óculos de acetato, calça jeans e está em frente ao fogão de sua pequena cozinha, decorada com tons claros. Ao ver essa imagem, a inteligência artificial, regida por algoritmos, não tem dúvida e, graças à sua sofisticada aprendizagem, rotula assim: cozinha, espátula, fogão, mulher. Se está numa cozinha, em frente ao fogão, deve ser uma mulher

Tecnologias racistas:

- Algoritmo do Snapchat não reconhece rostos negros. Artigo de Toni Oloko sobre o não reconhecimento de seu rosto negro no uso de filtro do Snapchat

- Algoritmo de reconhecimento facial falha para rostos negros

- O Google Photos rotulou pessoas negras como gorilas

- As fotos de pessoas usuárias negros do Flickr são classificadas como “chimpanzés”.

- O software da Nikon adverte quem está fotografando de que alguém piscou quando a pessoa retratada tem olhos puxados.

- As webcams da HP não podem identificar e seguir os rostos de pessoas negras, mas o fazem com os brancos.

- O primeiro concurso de beleza julgado por um computador colocou uma única pessoa de pele escura entre as 44 pessoas vencedoras.

- Nos Estados Unidos, a Amazon deixa fora de suas promoções os bairros de maioria afro-americana (mais pobres).

- Uma pesquisa da Universidade Carnegie Mellon descobriu que as mulheres têm menos chances de receber anúncios de emprego bem remunerado no Google.

- Os programas usados nos departamentos de contratação de algumas empresas mostram uma inclinação por nomes usados por pessoas brancas e rejeitam os de pessoas negras ou de grupos étnicos minoritários.

- Alguns sistemas de reconhecimento de pessoas para carros autônomos erram mais com pedestres negros, gerando risco de atropelamentos.

- Três sistemas de reconhecimento facial – IBM, Microsoft e Megvii da China – eram mais propensos a identificar erroneamente o gênero de pessoas de pele escura (especialmente mulheres) do que de pessoas de pele clara.

Algoritmos de IA e Vieses: seus usos éticos e justos

Quando os sistemas de IA são alimentados com dados que não refletem a imparcialidade, a IA pode se tornar enviesada ou aprender a reforçar padrões discriminatórios. Sem mecanismos de regulamentação, responsabilidade e transparência, estes processos podem levar a perdas financeiras, perdas de audiência, de mercado, e à questões legais, além de levantar questões éticas e morais.

Se trata de desenvolver a confiança do público em Inteligência Artificial, garantindo que os sistemas que estão sendo desenvolvidos sejam responsáveis, para que não prejudiquem determinados grupos de indivíduos.

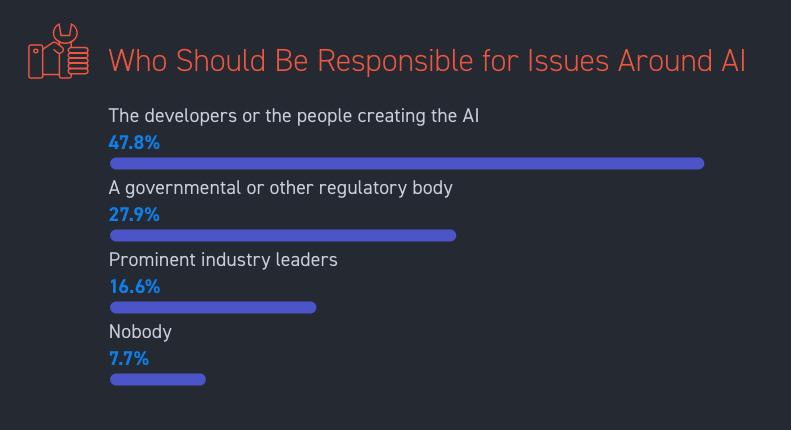

Segundo uma pesquisa da Stack Overflow com mais de cem mil pessoas desenvolvedoras ao redor do mundo em 2018: quase metade das pessoas criadoras e tecnólogas por trás da ML e IA deveriam ser as primeiras responsáveis por questões sociais envolvendo IA. E um terço considera que deveria ser um órgão regulatório.

Quem deve ser responsável por questões sobre IA?

– Pessoas desenvolvedoras ou criadoras da IA 47.8%

– Um órgão governamental ou regulatório 27.9%

– Lideranças referências na indústria 16.6%

– Ninguém 7.7%

Fonte: Inteligência Artificial – O que pessoas desenvolvedoras REALMENTE pensam sobre IA?

Interpretabilidade e Explicabilidade

Além da responsabilidade, é essencial que os sistemas de IA desenvolvidos sejam transparentes. Esta habilidade de conseguir explicar como as decisões e recomendações foram tomadas dentro dos algoritmos deve estar na base de desenvolvimento de qualquer IA. Porém, isso é um desafio técnico grande. “Um modelo de classificação simples, como um separador linear ou uma árvore de decisão, é possível entender o processo lógico usado para gerar um determinado resultado.

Entretanto, a medida que os modelos se tornam mais uma complexos, o entendimento da contribuição de cada um dos atributos na produção de um determinado resultado passa a ser uma tarefa dificultosa”, escreve o engenheiro de software Victor Antoniazzi no texto Interpretabilidade e Inteligência Artificial. A popularização de modelos mais complexos, como os de Deep Learning, que se caracterizam pelas diversas camadas de redes neurais sobrepostas – e, quanto mais profundos, menos interpretáveis as redes se tornam-, levantou a urgência de se estudar formas para interpretar e explicar os algoritmos de Machine Learning, muitas vezes opacos, conhecidos como “caixa preta”. Isso também é uma estratégia para aumentar a confiança na utilização desses algoritmos, um desafio para adoção de tecnologias de IA hoje como um todo – a gente tende a confiar apenas no que entende.

É por isso que aumentam as pesquisas nas áreas de Interpretabilidade e Explicabilidade. Apesar de serem utilizados quase de forma intercambiável, há uma pequena sutileza: “Interpretabilidade é a possibilidade de observar a relação de causa e efeito dentro de um sistema, de entender o que está acontecendo no algoritmo sem necessariamente entender o porquê. Enquanto explicabilidade é poder explicar em termos humanos a mecânica interna da máquina”. (Machine Learning Explainability vs Interpretability: Two concepts that could help restore trust in AI)

Diversidade como estratégia para criar sistemas de IA mais justos

A criação de sistemas de IA mais justos também demanda a garantia de que os sistemas de IA reflitam os valores das pessoas ou população para quem vão servir. A diversidade e a inclusão são essenciais neste contexto. Quanto mais diversidade houver nas equipes de desenvolvimento dos sistemas que utilizam IA, menos erros e vieses elas terão.

Como tornar estes processos mais inclusivos se, segundo o Fórum Econômico Mundial, em 2020:

- As mulheres seguem subrepresentadas entre a força de trabalho com habilidades técnicas disruptivas (associadas à IA, robótica, engenharia genética)?

- As mulheres em IA e Ciência de Dados são 26% no mundo, contra 74% de homens, e somente 18% no Brasil? (isso que nem nos referimos à proporção de mulheres negras, periféricas, e representantes de outros grupos minoritários!)

Diante desse cenário desafiador, quais são os caminhos possíveis para combater os impactos negativos da IA? É sobre isso que falamos na Live Algoritmos de IA e Vieses com Fernanda Carreira (UFRJ), Carla Vieira (Loggi) e Bianca Ximenes (Gupy).

Quer saber mais sobre Algoritmos de IA e Vieses?

- Playlist de vídeos da plataforma TED sobre vieses e tecnologia (em inglês com legenda em português)

- Palestra TED Kriti Sharma – How to keep human bias out of AI (em inglês com legenda em português)

- Ferramenta para dinâmicas sobre como enfrentar vieses (em inglês)

- Livros que falam sobre raça e tecnologia do Tarcizio Silva

- Vieses e a importância de sempre analisar o cenário completo

- Trailer do filme “Bias”, de Robin Hauser, diretora do filme “CODE: Debugging the Gender Gap” (em inglês)

- Série do NY Times sobre vieses (em inglês)

- Sistemas discriminatórios – Gênero, Raça e Poder em IA (em inglês)

- Inteligência artificial corre o risco de se tornar muito masculina – nova pesquisa (em inglês)

- Explorando o desequilíbrio de gênero na IA: números, tendências e discussões (em inglês)

- Deficiência, viés e IA (em inglês)

Referências

- Vieses inconscientes, equidade de gênero e o mundo corporativo

- Does AI have a gender problem? (em inglês)

- Por que mais mulheres precisam trabalhar com inteligência artificial?

- Meetup Nubank – Interpretabilidade em Machine Learning

- ML e o víes da vida real – Karina Piva

- Racismo Institucional – Teste de Imagem – Campanha Governo do Paraná

- Viés de género na IA: construindo algoritmos mais justos

Achei o conteúdo perfeito. Ótimo para reflexões e debates e como aprimorar a tecnologia frente à temas de extrema importância como a abordagem da diversidade.

Muito bom o artigo , me foi útil para colaborar em uma discussão atual sobre provedores de internet

Excelente artigo, me ajudou muito entender sobre os viés, tanto visado pelo ser humano quanto pelas maquinas.